DeepSeek可以在网页端使用,但是有些时候可能不是很稳定,除了网页端,也能通过本地部署来使用。下面就一起来看看吧

配置要求

- Windows 配置:

- 最低要求:NVIDIA GTX 1650 4GB 或 AMD RX 5500 4GB,16GB 内存,50GB 存储空间

- 推荐配置:NVIDIA RTX 3060 12GB 或 AMD RX 6700 10GB,32GB 内存,100GB NVMe SSD

- 高性能配置:NVIDIA RTX 3090 24GB 或 AMD RX 7900 XTX 24GB,64GB 内存,200GB NVMe SSD

- Mac 配置:

- 最低要求:M2 MacBook Air(8GB 内存)

- 推荐配置:M2/M3 MacBook Pro(16GB 内存)

- 高性能配置:M2 Max/Ultra Mac Studio(64GB 内存)

本地部署工具Ollama使用方法

1. 在加速界面可一键下载(windows版本)

2. 安装完成

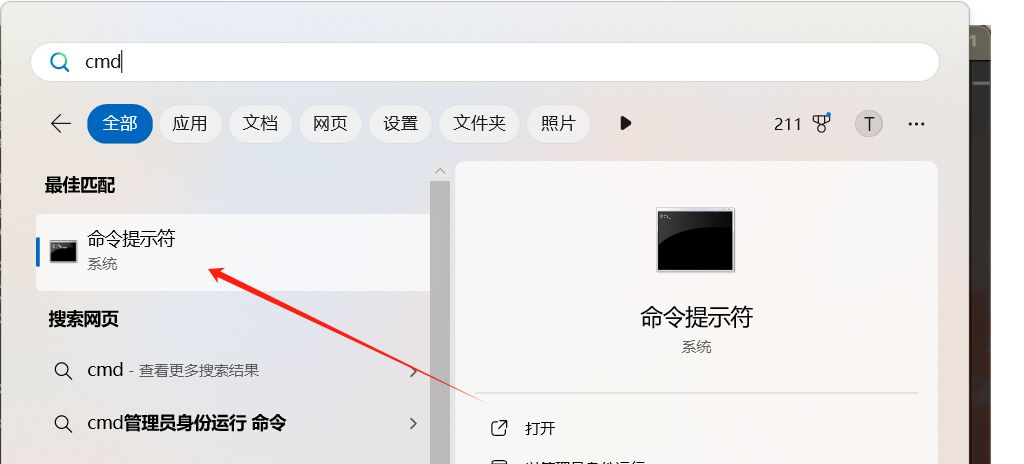

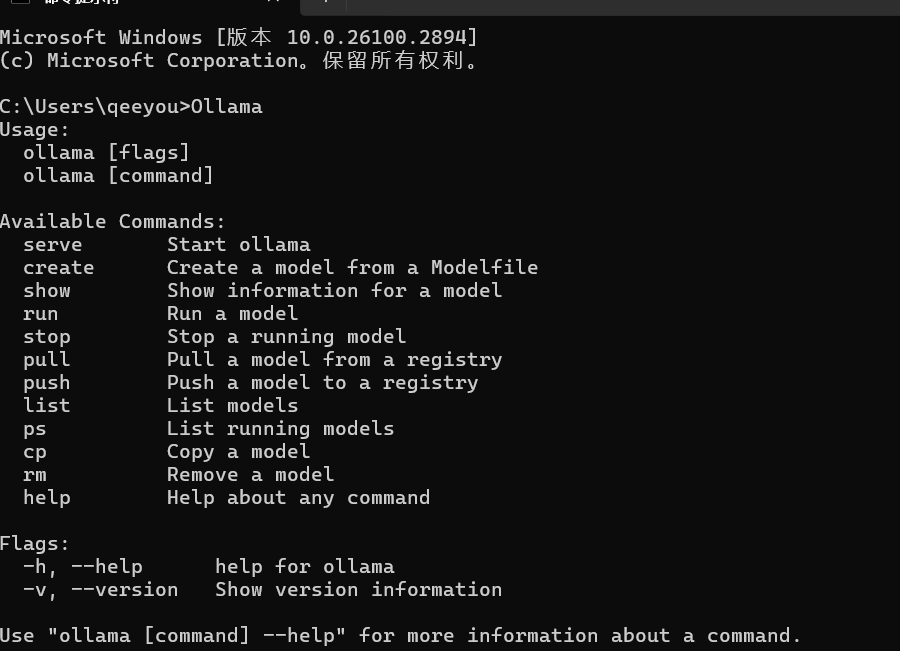

3. 按Win键输入cmd打开并输入【Ollama】后按下回车,如下图所示即为安装成功;

4. 安装命令如下:安装完成后出现【success】则代表安装成功

1. 内存低于4GB安装命令如下:

ollama run deepseek-r1:1.5b2. 内存在8GB-12GB安装命令如下:

ollama run deepseek-r1:7bollama run deepseek-r1:8b3.内存在12GB以上安装命令如下:

ollama run deepseek-r1:14b4.内存在32GB以上安装命令如下:

ollama run deepseek-r1:32b5.内存在70GB以上安装命令如下:

ollama run deepseek-r1:70b注意:内存越高,效果越好,但占用储存会更多。

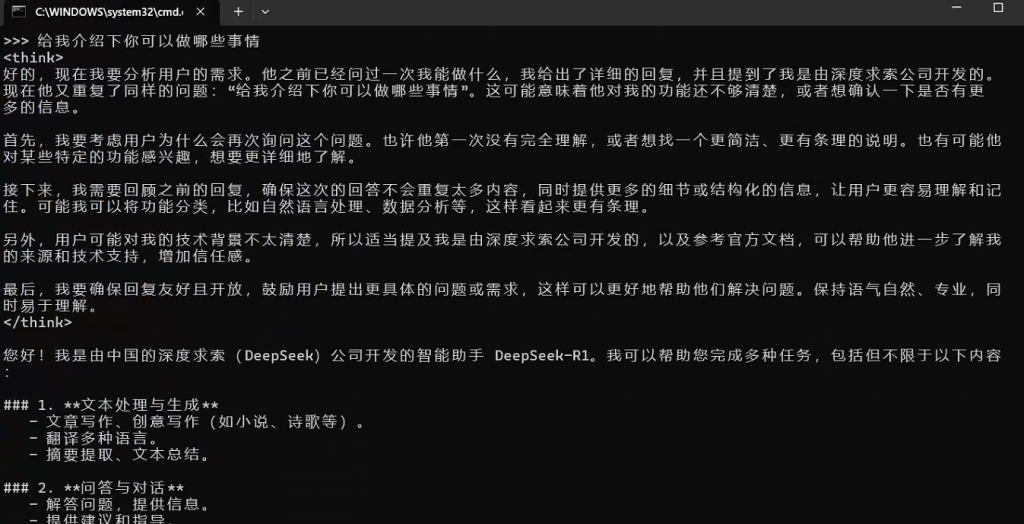

5. 此时我们可以直接在终端下提问,DeepSeek-R1会在终端下回答。

但是在终端界面提问的话,很不方便,每次提问都需要输入指令,可参考下方可视化以便后续试用

安装可视化WebUI客户端

提示:此WebUI需要搭配Chrome浏览器,请提前下载Chrome,在Chrome中运行。

chrome下载链接:https://www.google.cn/chrome/

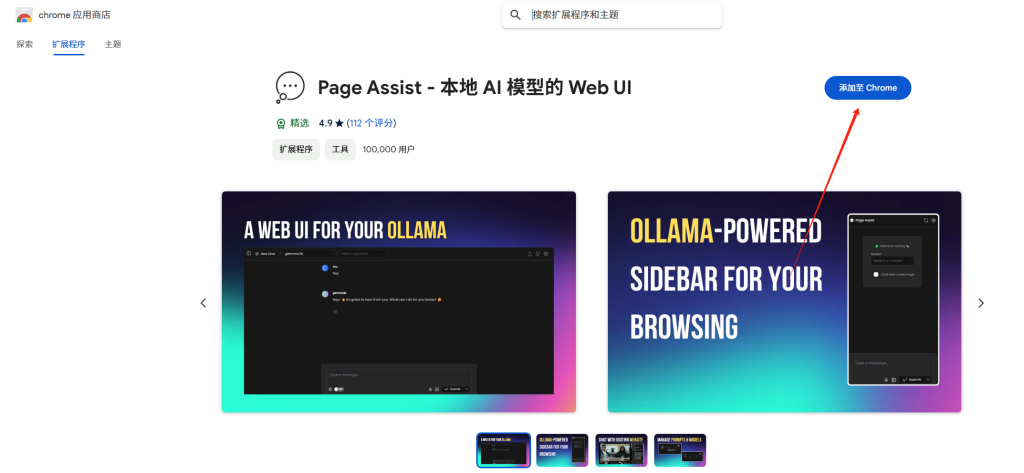

WebUI下载:https://chromewebstore.google.com/detail/page-assist-%E6%9C%AC%E5%9C%B0-ai-%E6%A8%A1%E5%9E%8B%E7%9A%84-web/jfgfiigpkhlkbnfnbobbkinehhfdhndo

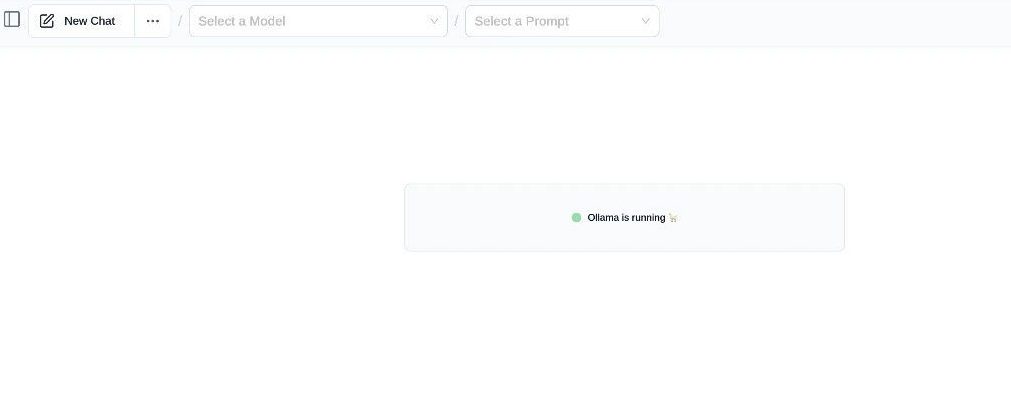

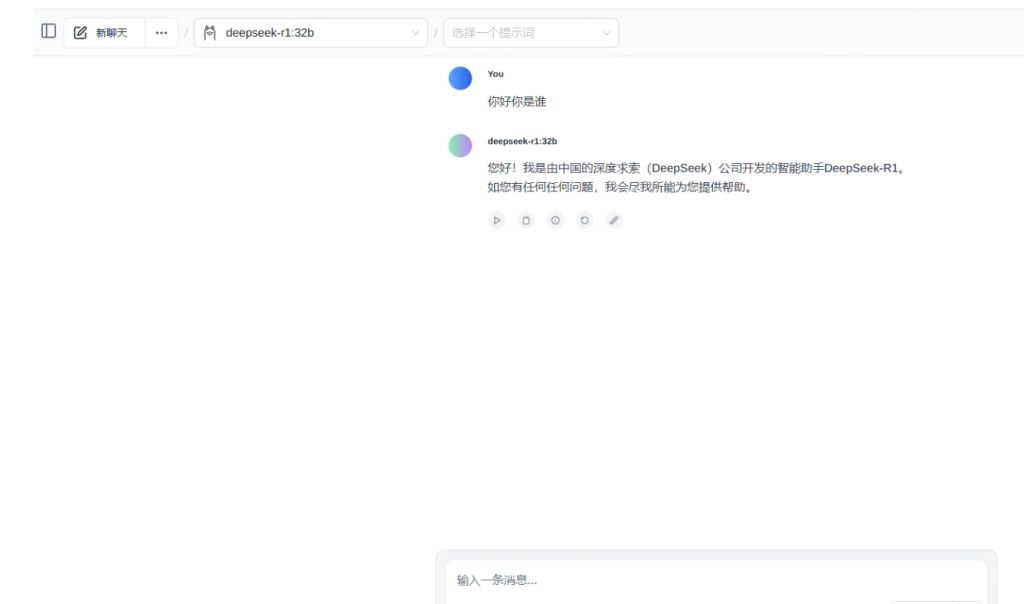

- 打开浏览器插件,如果可以看到“Ollama is running”代表插件已经识别到Ollama。

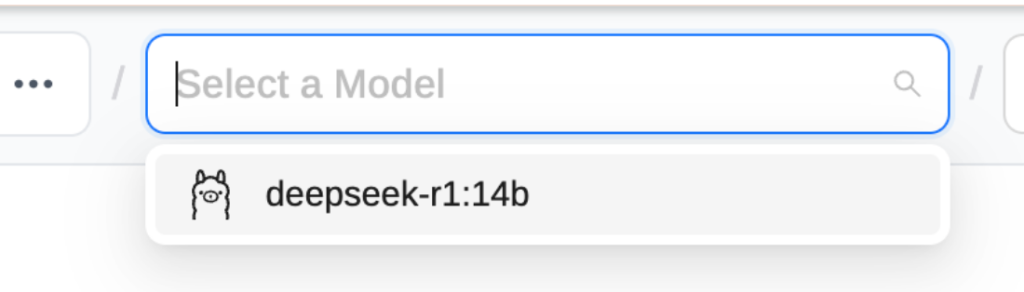

- 点击左上方“Select a Model”,选择“DeepSeek-R1”

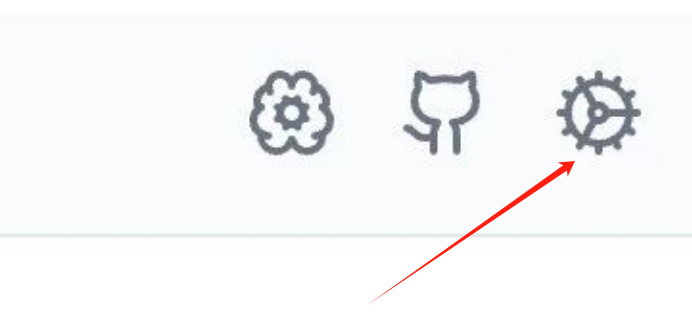

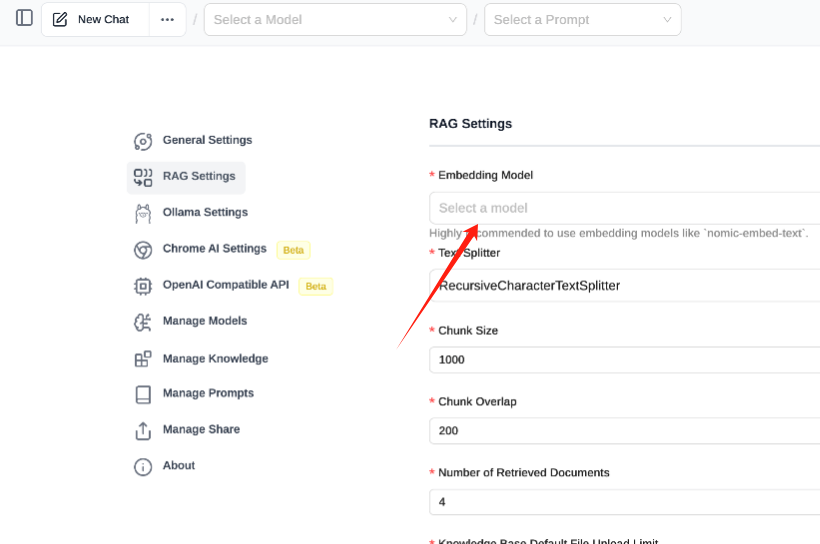

- 选择完成后,在页面右上角点击小齿轮图标进入设置。

- 在左侧的“RAG Settings”中,把右侧的Embedding Model选择成“DeepSeek-R1”

- 最后点击右下角的“Save”,后续就可以在WebUI端使用啦

-_01.png)